C’era una volta la cibernetica. La “scienza del controllo” – dal greco κυβερνήτης, l’auriga o il timoniere marittimo – ovviamente esiste sempre ma il termine stesso, introdotto da Norbert Wiener nel 1947, sembra oggi caduto largamente in disuso nel discorso comune, sostituito da altri, più allettanti e contemporanei, a cominciare dall’eminente ossimoro di “Intelligenza Artificiale”. Lo registra a sua volta il mondo accademico dove la cibernetica figura per lo più come materia di studio complementare, all’interno dei curricula di computer science, ingegneria robotica, matematica computazionale ecc, in un numero di facoltà costantemente in calo a partire dagli anni ‘70. Non sembra incidentale, quindi se di cibernetica si torna a parlare oggi, da una prospettiva solo in parte archeologica, dopo lo sconquasso che la narrativa del machine learning e l’hype del determinismo tecnologico ha prodotto in questa nuova fase storica, e si torna a parlarne anche grazie a due libri usciti a distanza di pochi mesi in lingua inglese e non ancora tradotti in Italia. Uno è il primo volume della serie Cybernetics for the 21st Century (Hanart Press, 2024) a cura di Yuk Hui – filosofo, informatico, ex dottorando con Bernard Stiegler, originario di Hong Kong, in cattedra presso la Erasmus University Rotterdam – con testi, tra gli altri, di Katherine Hayles e Andrew Pickering[1], ed è una riflessione sull’eredità filosofica della cibernetica e dei suoi approdi storici nelle diverse culture e latitudini geopolitiche. L’altro è The Eye of the Master: A Social History of Artificial Intelligence (Verso Books, 2023) di Matteo Pasquinelli, professore associato di Filosofia della Scienza a Ca’Foscari, un imponente studio sul ruolo della macchina nella divisione del lavoro, nell’arco che va dal capitalismo manifatturiero – ma già “algoritmico” – di Babbage all'”automazione dell’automazione” che l’intelligenza artificiale prospetta oggi e che la prima ondata cibernetica degli anni ‘50 aveva in parte prefigurato.

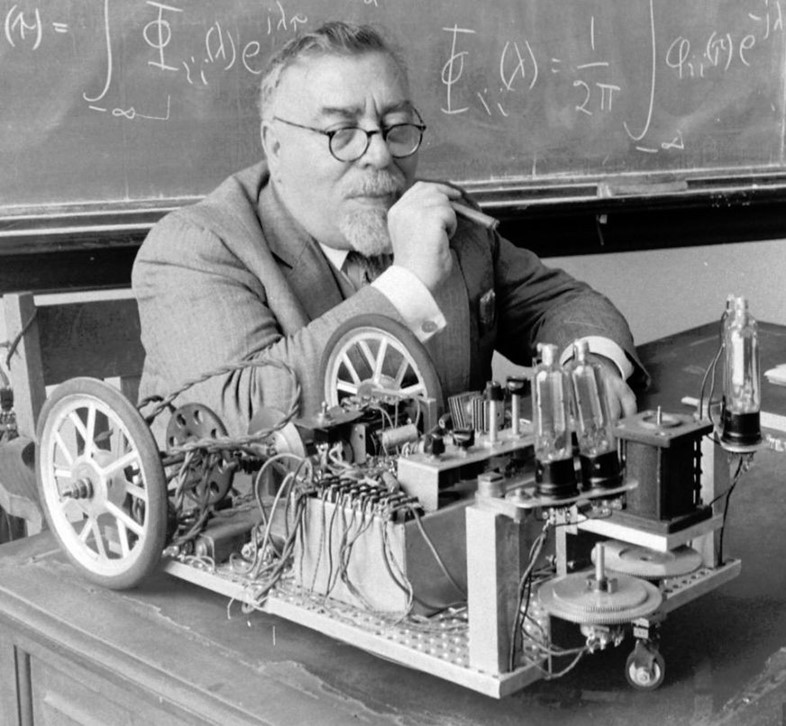

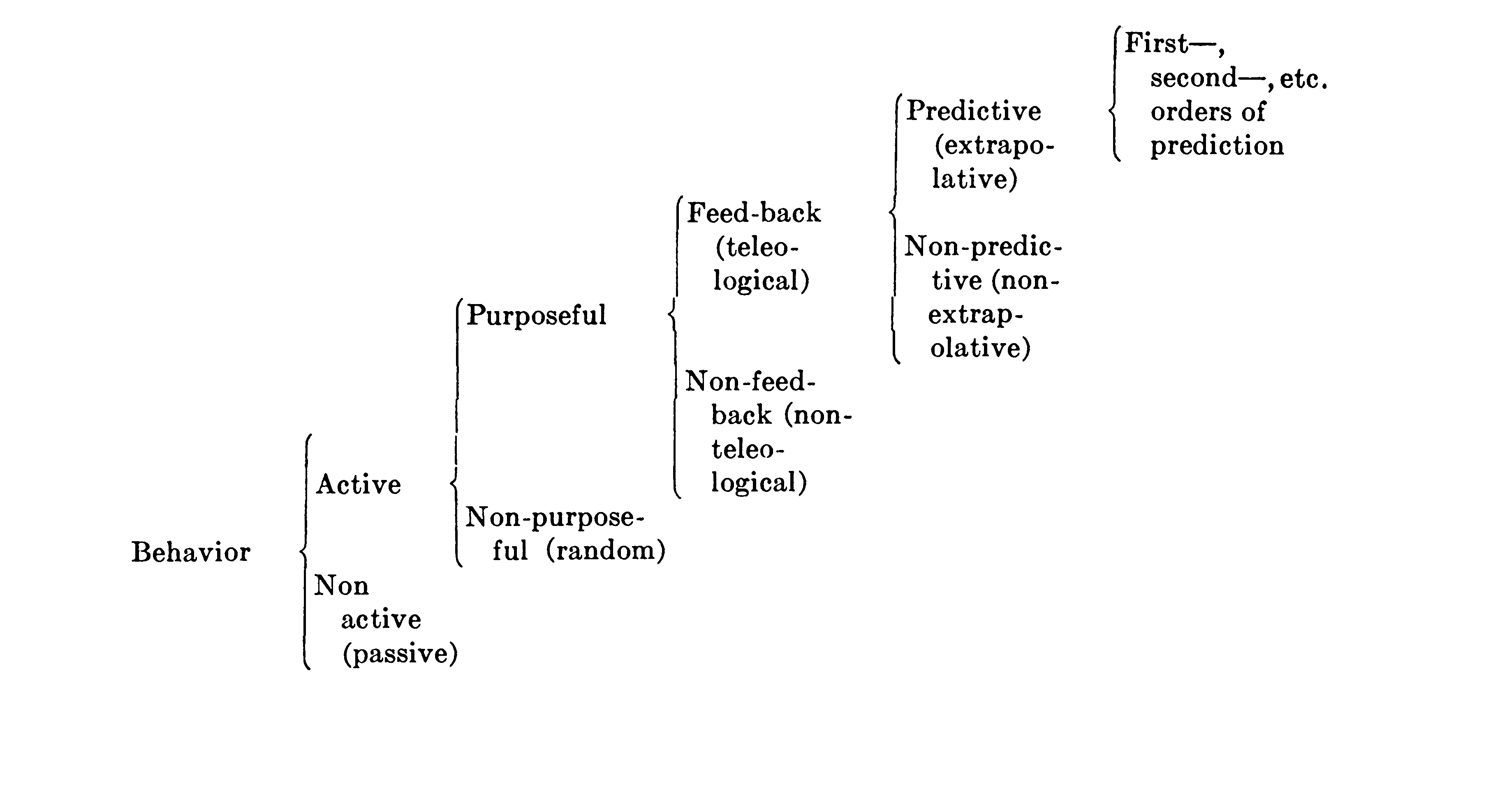

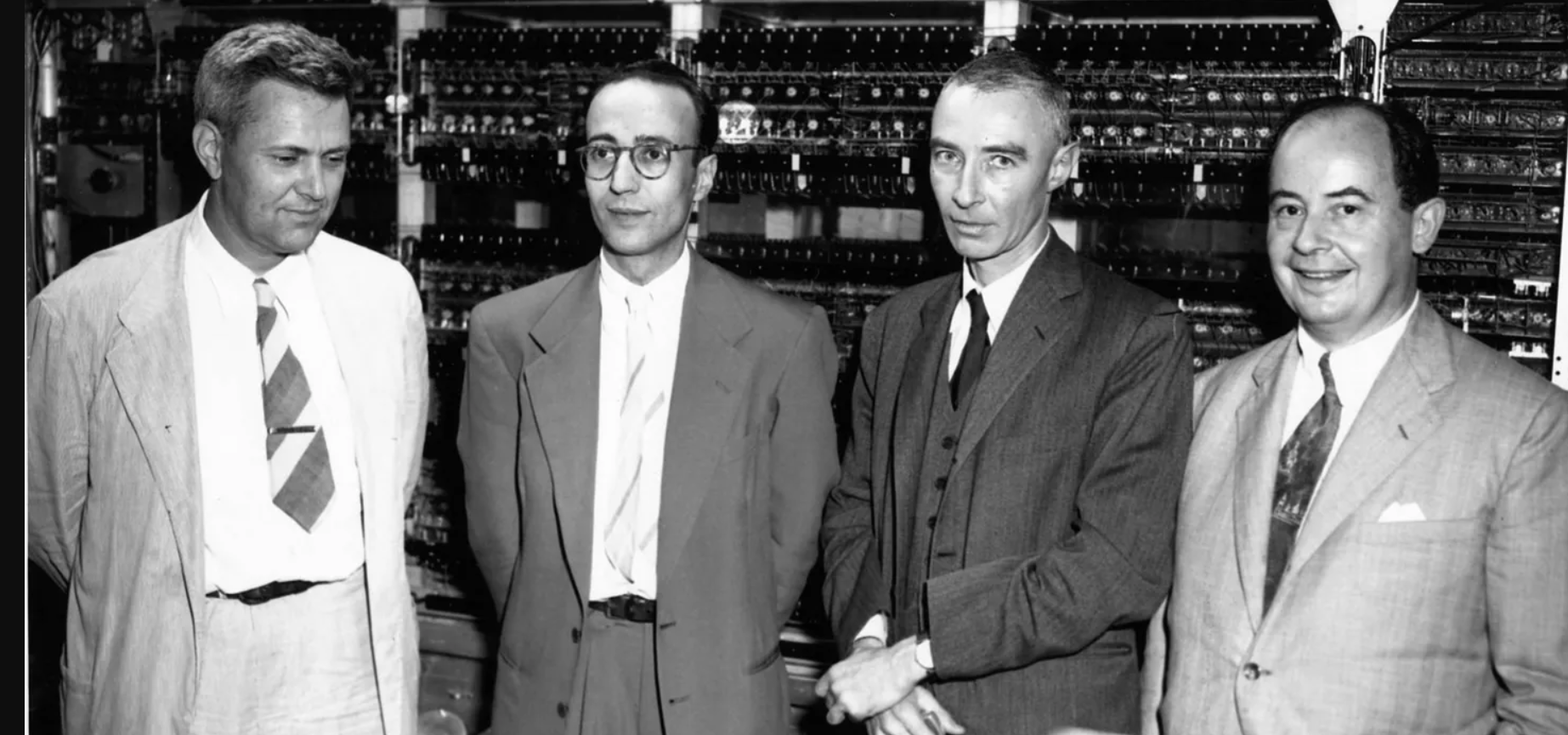

Ma che cosa è la cibernetica? Schematizzando un metodo scientifico multidisciplinare, che ha visto per protagonisti soprattutto matematici, neurofisiologi e scienziati sociali come John von Neumann, Walter Pitts, Warren McCulloch, Gregory Bateson, Margaret Mead in una prima ondata nel secondo dopoguerra, e biologi come Humberto Maturana e Francisco Varela, in una successiva, a cavallo degli anni ‘70-90. Il paradigma cibernetico, descritto da Wiener nel suo testo seminale Cybernetics or Control and Communication in the Animal and the Machine (1948)[2], anticipato cinque anni prima in un paper fulminante con lo psicologo messicano Arturo Rosenblueth e con Julian Bigelow[3], si basa – schematizzando ancora – sul concetto nodale di feedback, che lega sistemi animati e inanimati a catene di retroazione in grado di autoregolarsi. Wiener parte dalla sua esperienza diretta e dai sistemi di puntamento messi a punto per automatizzare la ricerca dei bersagli nemici durante la guerra. Omeostasi e ricorsività sono tra i concetti chiave di una visione che assimila informazione e materia, e guarda al comportamentismo non meno che alla psicologia della Gestalt e alla teoria booleana della comunicazione che Claude Shannon ha appena sviluppato per i circuiti elettronici. Per un filosofo della tecnica come Gilbert Simondon, si tratta di una rivoluzione paragonabile a quella del meccanicismo cartesiano quattro secoli prima, per Heidegger, notoriamente, di una campana che suona a morto annunciando la fine della filosofia occidentale.

La cibernetica decolla nel discorso scientifico attorno al ciclo delle conferenze presso la Josiah Macy Jr. Foundation (1946-1953) da cui emerge anche il primo confronto sull’intelligenza artificiale attorno alle tesi connessioniste di Pitt e McCulloch, materializzate dal prototipo del Perceptron, poi realizzato da Frank Rosenblatt nel ‘57: un computer mainframe collegato a una telecamera a bassa risoluzione che per la prima volta “impara” – passando per un processo di apprendimento per tentativi, trial and failure – a riconoscere immagini di 20×20 pixel. Dall’approccio stocastico dei “connessionisti” discendono oggi le tecniche di pattern recognition, le reti neurali e il machine learning che, quando i costi di elaborazione bruta – e la disponibilità di miliardi di contenuti reperibili in rete per il training degli algoritmi – lo consentiranno, escono dai laboratori degli anni ‘90 per approdare alle piattaforme commerciali del XXI secolo. In mezzo, come noto, il lungo “inverno dell’AI”, durante il quale l’approccio simbolico di Marvin Minsky e John McCarthy, focalizzato sull’euristica dei sistemi esperti e gli skill verticali, ruba per un paio di decenni la scena (e i fondi della ricerca militare e civile), registrando il flop più clamoroso forse al di là del Pacifico, con il fallimento della reclamizzata Quinta Generazione giapponese degli anni ‘80.

The eye of the master ripercorre attraverso due secoli e mezzo la storia dell’automazione dal primo capitalismo industriale ai giorni nostri. Accanto all’evoluzione del modello economico emerge così una costante: in ogni epoca l’introduzione della macchina – sia essa meccanica, cognitiva, ecc – configura la nuova divisione del lavoro astraendo e meccanizzando le competenze realizzate collettivamente nella fase precedente, anche in funzione dello stadio di disponibilità di fonti naturali stabili – acqua, carbone, petrolio… – rese cioè “computabili in termini di costo, trasporto, stock, performance, organizzazione”.[4] Per Pasquinelli la macchina non è infatti tecnologicamente determinata ma sempre socialmente orientata: impiegata per estrarre il profitto dal ciclo produttivo fornisce, al tempo stesso, il cruscotto per misurarlo e il panopticon per mantenerlo sotto controllo, a cui fa riferimento anche il titolo del libro. La distinzione stessa tra lavoro manuale e intellettuale risulta ideologicamente costruita in funzione di un’organizzazione specifica che nega, ad esempio, in fabbrica il lavoro cognitivo dell’operaio di fatica. Si tratta di un punto chiave nello sviluppo del saggio – che sceglie non per caso di utilizzare la concettualizzazione marxiana di general worker, impiegata ne Il Capitale, in luogo di quella di general intellect adottata dieci anni prima da Marx nei Grundrisse – che vede la luce mentre allo stato dell’arte le tecniche di machine learning riescono oggi a emulare, contro le previsioni di Turing e di altri, le mansioni di un quadro intermedio o di un notista finanziario assai meglio che il lavoro intellettuale di un camionista.

Se il punto di partenza del libro è la divisione del lavoro, il suo indiscusso protagonista è inizialmente Charles Babbage (1791–1871), il matematico britannico che progettò il primo computer meccanico senza mai vederlo realizzato. Per programmare la sua macchina analitica Babbage prevede lo stesso sistema a schede già impiegato da alcuni decenni nella filatura manifatturiera dai telai Jacquard. Se Lady Lovelace, la sua assistente, viene oggi ricordata per l’acutezza presaga delle sue note,[5] Babbage incarna invece il perfetto imprenditore smithiano, un visionario della divisione del lavoro, oggi diremmo uno startupper, che con la sua precedente calcolatrice polinomiale (macchina inferenziale) ha già “astratto” il lavoro più comune per un impiegato del tempo – fare di conto – con un algoritmo, ossia una procedura meccanica step-by-step. Quello di Babbage è ovviamente un modello, che si riproduce attraverso le fasi del capitalismo manifatturiero e poi industriale. Riprendendo le osservazioni di Romano Alquati, per comprendere cosa è successo veramente va però rovesciato il modello top-down, “implicito nel concetto stesso di controllo dell’informazione”: il flusso dei dati non è prodotto dalla macchina ma generato dal general worker e risucchiato verso l’alto. Analogamente, potremmo dire oggi, le piattaforme social alimentano da anni con i nostri selfie quelle di machine learning, addestrate a distinguerle e a catalogarle da un esercito di “turchi meccanici” umani sottopagati.

Di qui il saggio affronta nella seconda parte la nascita della cibernetica e la sua golden age che, anche grazie al palcoscenico delle Macy Conference, fornirà nel secondo dopoguerra una strumentazione completamente nuova alle scienze sociali non meno che alla prima generazione dell’Intelligenza Artificiale. Una scatola degli attrezzi che i cibernetici incubano con i concetti di autorganizzazione e di ricorsività sistemica, per governare la complessità della fabbrica sociale che, ancora dormiente sotto la coltre dei Trente Glorieuses, emergerà solo alcuni anni più tardi dalle macerie del fordismo, per approdare in questo secolo alla “rivoluzione digitale” e, ora, con le AGI (Artificial General Intelligence) a un modello generalizzabile e ormai definibile secondo Pasquinelli come “automazione dell’automazione”[6] Ma, tornando agli anni ‘50, il saggio individua le figure chiave di questa fase pionieristica in John von Neumann e Friedrich Hayek. L’autorevolezza del primo[7], prematuramente scomparso nel ‘57, ha rappresentato a lungo, secondo questa ricostruzione, un punto di equilibrio per la comunità dei cibernetici e un approdo anche per i “connessionisti”. Dal canto suo, l’economista angloaustriaco – che in quegli anni svolge un ruolo seminale nella nascita della cosiddetta Chicago school – vede nel dibattito sulla Gestalt e nella cibernetica i mezzi intellettuali per rinnovare in chiave sistemica i modelli dell’economia (neo)liberale.

Perché la cibernetica oggi? Secondo Yuk Hui perché “Il XXI secolo è il secolo della cibernetica. Molti hanno cercato di distinguere la cibernetica dall’intelligenza artificiale e l’intelligenza artificiale dal machine learning. È chiaro che la cibernetica e l’AI attuale appartengono a due epoche diverse ma è innegabile che la cibernetica ha posto un fondamento epistemologico per la moderna automazione”.[8] Perchè, in sostanza, non di un pensiero tecnologico si è trattato ma “come direbbe Heidegger di un metodo scientifico generalizzato o di una completa metafisica”[9]. Da questa angolatura, il progetto di Cybernetics for the 21st Century si propone di “riesaminare criticamente le possibilità che la cibernetica ha provato ad aprire e le sue potenziali applicazioni per una ricerca realmente interdisciplinare” e questo primo volume presenta almeno due tracce significativamente rivolte ad un supplemento di indagine. La prima rileva nella riflessione dei cibernetici la premessa epistemica e politica di un nuovo materialismo che Mathieu Triclot, in particolare, fa risalire già direttamente al Wiener di The Human use of human beings (1950), quello che osserva come l’ideale americano del progresso industriale mostri “poche inibizioni quando si tratta di trarre profitto da un nuovo settore e lasciare che sia poi il pubblico a rimettere assieme i pezzi”[10]. Per Triclot, soprattutto, Wiener, che nega la natura immateriale dell’informazione, sfida il discorso del dualismo digitale e ci invita a esaminare la mediazione materiale, tecnica ed estrattiva sottostante a qualsiasi sistema informativo. Le premesse metodologiche evolvono inoltre, significativamente, con la cibernetica cosiddetta di secondo ordine (o “cibernetica della cibernetica”, secondo la definizione di Maed), una volta ricondotto anche il punto di vista dell’osservatore, e quindi dello scienziato, dall’esterno all’interno dei sistemi dinamici, coinvolto esso stesso come oggetto del modello.

Perché la cibernetica oggi? Secondo Yuk Hui perché “Il XXI secolo è il secolo della cibernetica. Molti hanno cercato di distinguere la cibernetica dall’intelligenza artificiale e l’intelligenza artificiale dal machine learning. È chiaro che la cibernetica e l’AI attuale appartengono a due epoche diverse ma è innegabile che la cibernetica ha posto un fondamento epistemologico per la moderna automazione”.[8] Perchè, in sostanza, non di un pensiero tecnologico si è trattato ma “come direbbe Heidegger di un metodo scientifico generalizzato o di una completa metafisica”[9]. Da questa angolatura, il progetto di Cybernetics for the 21st Century si propone di “riesaminare criticamente le possibilità che la cibernetica ha provato ad aprire e le sue potenziali applicazioni per una ricerca realmente interdisciplinare” e questo primo volume presenta almeno due tracce significativamente rivolte ad un supplemento di indagine. La prima rileva nella riflessione dei cibernetici la premessa epistemica e politica di un nuovo materialismo che Mathieu Triclot, in particolare, fa risalire già direttamente al Wiener di The Human use of human beings (1950), quello che osserva come l’ideale americano del progresso industriale mostri “poche inibizioni quando si tratta di trarre profitto da un nuovo settore e lasciare che sia poi il pubblico a rimettere assieme i pezzi”[10]. Per Triclot, soprattutto, Wiener, che nega la natura immateriale dell’informazione, sfida il discorso del dualismo digitale e ci invita a esaminare la mediazione materiale, tecnica ed estrattiva sottostante a qualsiasi sistema informativo. Le premesse metodologiche evolvono inoltre, significativamente, con la cibernetica cosiddetta di secondo ordine (o “cibernetica della cibernetica”, secondo la definizione di Maed), una volta ricondotto anche il punto di vista dell’osservatore, e quindi dello scienziato, dall’esterno all’interno dei sistemi dinamici, coinvolto esso stesso come oggetto del modello.

È un salto teorico che nei decenni successivi si presenta con l’autorganizzazione e i sistemi autopoietici di Maturana e Varela in Cile, la teoria della complessità biologica di Stuart Kauffman a Santa fè, ma anche con l’ipotesi Gaia di James Lovelock e Lynn Margulis, qui richiamata anche dal figlio, Dorian Sagan. Per Yuk Hui sono evidenti le affinità della cibernetica con l’approccio sistemico di un’altra disciplina, l’ecologia, tanto da configurare un’ipotetica “ecologia delle macchine” che superi i limiti finora intrinseci allo studio del progresso tecnologico, inteso sia come evoluzione degli oggetti tecnici che in relazione all’interazione con gli umani. Una prospettiva che si fonde in parte anche con le premesse della terza e ultima ondata, o neurocibernetica, teorizzata ad esempio dall’americano Bruce Clarke e dal giapponese Toru Nishigaki, che distingue gli organismi viventi in quanto sistemi cibernetici chiusi, o autonomi, dai sistemi inanimati aperti e non autonomi. In questo schema tutta l’informazione è generata dal vivente, dotato di volontà propria ma visto a sua volta come allogeno – e non dissimile in questo da un dispositivo artificiale inanimato – dal livello superiore del sistema sociale in cui si trova a vivere. Una prospettiva che, come rileva Katherine Hayles, “incorpora la co-evoluzione di umani e macchine in un framework cognitivo integrato”[11].

La seconda traccia di Cybernetics for the 21st Century conduce invece a esaminare le onde che la tempesta provocata dalla nascita della cibernetica negli anni ‘40-’50 ha disseminato nel corso dei decenni successivi sulla battigia culturale e antropologica. Slava Gerovitch mette in luce ad esempio come in una fase pionieristica l’idea di una “macchina pensante”, in grado di emulare il comportamento umano, abbia suscitato tra i ricercatori americani e sovietici aspettative dissimili, legate a valori culturali molto diversi: se per i primi l’idea di autonomia cognitiva ruotava attorno al concetto individuale di “scelta” , e li portava a verificarlo nel labirinto del problem solving, per i secondi riguardava piuttosto i concetti di creatività e di astrazione rispetto proprio a quelle medesime “scelte” che in URSS erano invece consuetudine del partito. Anche assegnando queste notazioni all’inevitabile folklore nerd, le onde della cibernetica non si sono ovviamente fermate alle fantasie più o meno ben intenzionate degli informativi, riverberando invece, come analizzano i saggi presenti nella seconda parte del libro, in modo del tutto imprevisto sui destini politici delle popolazioni. Prova ne sia proprio la parabola di un Paese come la Cina, dove, dopo l’ascesa di Deng, e grazie a scienziati come Qian Xuesen, divenuto padre della missilistica cinese dopo essere stato espulso dagli Usa sull’onda del maccartismo, l’utopia marxista si congiunge al progetto cibernetico. Un progetto totalmente “top down” che ha scaraventato la Cina nel futuro nell’arco di due sole generazioni, ma che spiega tra le altre cose anche la politica del figlio unico o la severità dei recenti lockdown durante la crisi pandemica.

Ma prova ne sia anche l’avventurosa storia della cibernetica in America Latina, cominciata già nel lontano 1952, con un computer ad acqua costruito per pianificare l’economia del Guatemala, durante la breve parentesi democratica di Jacobo Guzmán, e culminata con il celebre progetto Cybersyn voluto da Allende. Un progetto statale di “cibernetica democratica”, del secondo ordine, rivolto sia alla pianificazione pubblica in rete che alla partecipazione decisionale (feedback), inizialmente di alcune città campione. Nato dalla collaborazione del CORFO, l’agenzia governativa dello sviluppo economico, con il matematico e cibernetico inglese Stafford Beer, un teorico visionario dell’organizzazione, il progetto morirà con il golpe di Pinochet poco dopo aver visto la luce. Il suo modello, il VSM, basato su un sistema decisionale di 5 livelli, che David Maulen de los Reyes illustra nel suo saggio (Why did Cybernetics disappear from Latin America?) , non è l’unico a essere discusso e a girare negli anni ‘70 tra Cile, Perù, Argentina e altri paesi del Sud America. E la loro storia disconosciuta ci parla oggi di un’eredità politica non meno che di un’archeologia scientifica da riscoprire.

NOTE

- Gli autori dell’antologia sono Brunella Antomarini, Slava Gerovitch, Daisuke Harashima, Katherine Hayles, Yuk Hui, Dylan Levi King, Michał Krzykawski, David Maulen de los Reyes, Andrew Pickering, Dorion Sagan and Mathieu Triclot. ↑

- La cibernetica – Controllo e comunicazione nell’animale e nella macchina, Norbert Wiener, Il saggiatore, 1968 ↑

- Behavior, Purpose and Teleology, Arturo Rosenblueth, Norbert Wiener and Julian Bigelow, Philosophy of Science Vol. 10, No. 1 (Jan., 1943), pp. 18-24 (7 pages) ↑

- The Eye of the Master: A Social History of Artificial Intelligence, Matteo Pasquinelli, Verso Books, 2023. pp. 123 ↑

- Sketch of The Analytical Engine Invented by Charles Babbage, Luigi Federico Menabrea, R & J.E. Taylor, 1843 ↑

- The Eye of the Master: A Social History of Artificial Intelligence, Matteo Pasquinelli, Verso Books, 2023. pp. 246 ↑

- Il portatile su cui sto scrivendo, 79 anni dopo l’EDVAC, rispetta ancora l’architettura che prende il suo nome. ↑

- Cybernetics for the 21st Century Vol. 1: Epistemological Reconstruction ( Hanart Press, 2024) a cura di Yuk Hui, pp. 15 ↑

- ibid. ↑

- Weiner, The Human use of human being, in Ivi, pp. 80 ↑

- Ivi, pp. 97 ↑